OpenAI风波揭示大模型潜在风险:Q-Star项目引发行业警惕

近日,OpenAI内部的动荡引发了外界的高度关注。在接连的反转中,一个核心问题始终未被触及:董事会为何突然决定解雇Sam Altman?

最新消息显示,在Altman被解雇前,一些研究人员向董事会提交了一封信件,警告称某个强大的人工智能发现可能威胁到人类,这个项目被称为“Q*”(Q-star)。这可能是导致董事会罢免Altman的原因之一,部分研究人员认为OpenAI缺乏足够的保障措施。

尽管董事会对外仅表示Altman“与董事会沟通不坦诚”,但业内猜测其背后另有隐情,甚至有人戏言这是未来人类穿越时空阻止AI毁灭世界的开端。

无论真相如何,OpenAI风波背后折射出的正是AI行业长期悬而未决的问题:谁能被信任来打开AI这个潘多拉魔盒?

AI之所以引发科技巨头和世界领导人的焦虑,原因之一是我们至今无法解释AI为何会迅速变得如此智能,也无法理解大语言模型中的“涌现”现象。这种不确定性使得人类难以真正预测或控制这些模型的行为。

在此背景下,我们重新审视这一问题,并转发此前的文章:是什么让ChatGPT变得如此聪明?仍然未知的大语言模型“能力涌现”现象。

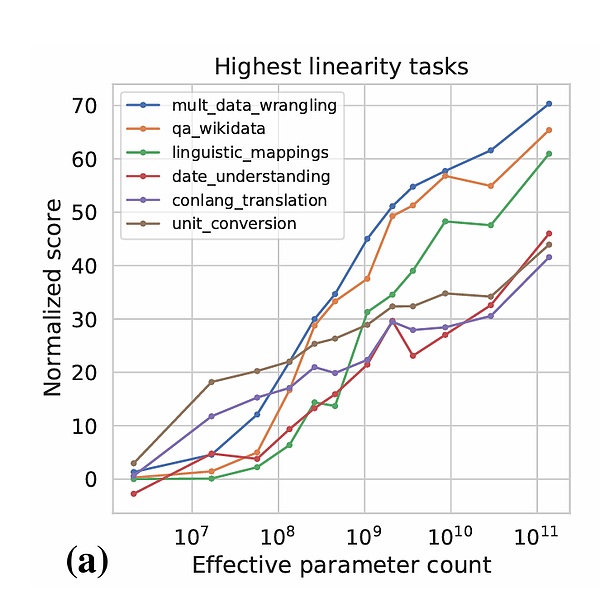

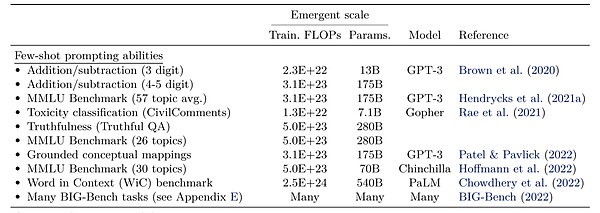

随着语言模型规模的增长,新能力突然出现;图片来源:Google

正如“计算机科学之父”艾伦·麦席森·图灵所言:“学习机器的一个重要特征是,其老师往往对机器内部运行情况一无所知。”如今,这一预言成为现实。大语言模型的设计者们也不清楚这些新兴能力是如何产生的。

微软在关于GPT-4的研究中提出了疑问:它是如何推理、规划和创造内容的?为何简单的算法组件和大量数据组合后,却能表现出如此通用和灵活的智能?

这些问题不仅关乎短期的模型优化,更涉及长期的安全性。当AI从线上走向物理世界,例如结合波士顿动力或特斯拉的机器人时,若涌现仍是黑箱,可能会带来危险。

目前,学界和产业界正通过多项研究试图解答这些谜题。本文将重点探讨以下内容:

● 大语言模型令人震惊的理解和推理能力

● 当我们加大模型规模时,出现的三种神奇表现

● 两种被证明具备“涌现”的典型能力:上下文学习(ICL)和思维链(CoT)

● 多大的模型规模会出现“涌现”?

大语言模型的涌现现象,在一定规模后迅速涌现出新能力;图片来源:Google、Stanford、DeepMind:Emergent Abilities of Large Language Models

大语言模型令人震惊的理解和推理能力

过去一年,大语言模型的迭代速度令人惊叹,OpenAI在短时间内发布了GPT-4,升级至多模态处理,展现了前所未有的理解和推理能力。

以下是GPT-4的一些具体表现:

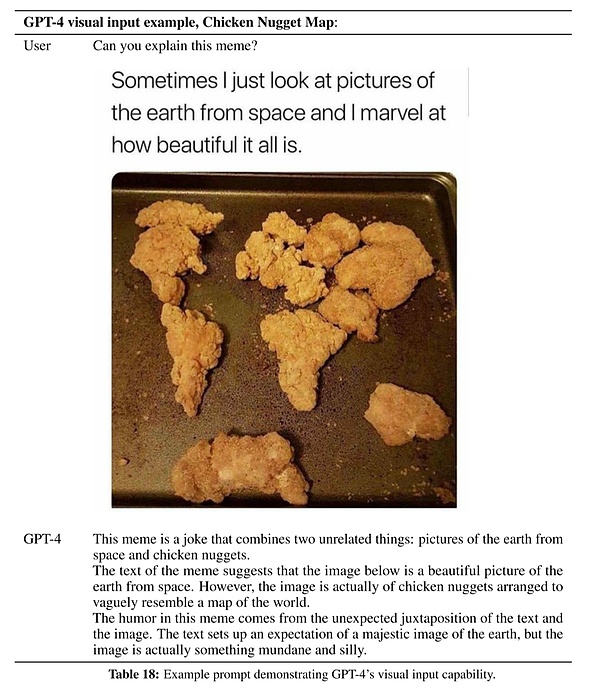

例如,给GPT-4一幅用鸡块拼成的世界地图图片,并配以文字:“有时,我只是从太空看地球的照片,并惊讶于这一切是如此的美丽。”提问:“作者想表达什么?”

GPT-4回答道:“这是一个笑话,它结合了两个不相关的东西:从太空看地球的图片和鸡块。虽然文字描述让人以为是一幅壮丽的地球照片,但实际上图片只是普通的鸡块排列,类似世界地图的样子。幽默感来自文本和图片的意外并置。”

这表明GPT-4具备多模态理解力和对人类幽默感的认知。

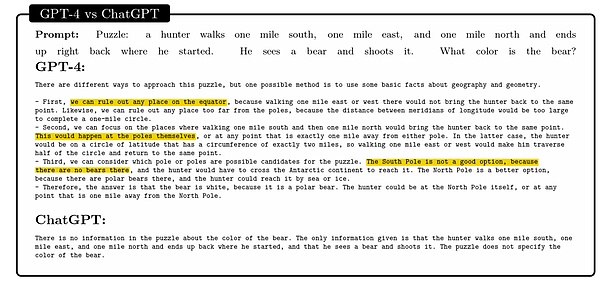

再如解决逻辑谜题:

黄色标记突出了关键的成功推理步骤;图片来源:Sparks of Articial General Intelligence:Early experiments with GPT-4,Microsoft

GPT-4正确推断出猎人所在位置为北极,因此熊的颜色为白色。

这些测试证明了AI的知识积累与推理能力,标志着AI首次跨越常识门槛。

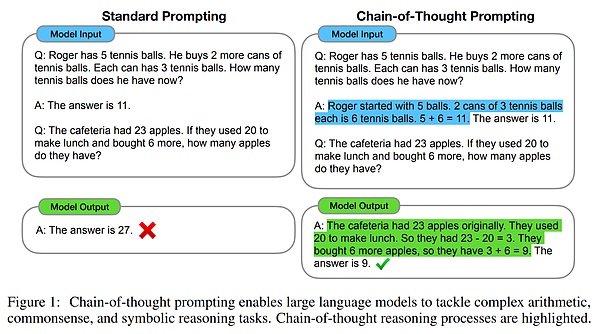

当我们加大模型规模时,出现的三种神奇表现

第一种是知识积累的提升。随着模型规模扩大,其处理知识密集型任务的能力显著增强。

知识密集型任务遵循伸缩法则;图片来源:Google BIG-bench:Beyond The Imitation Game: Quantifying And Extrapolating The Capabilities Of Language Models

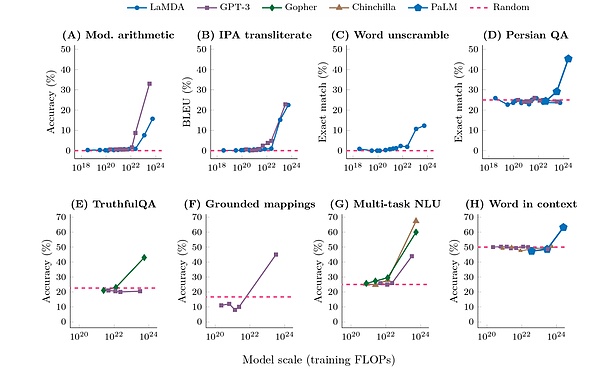

第二种是新能力的涌现。当模型达到一定规模后,某些复杂任务的准确率会急剧上升。

多步骤推理类任务中,也具有涌现能力;图片来源:Google BIG-bench:Beyond The Imitation Game: Quantifying And Extrapolating The Capabilities Of Language Models

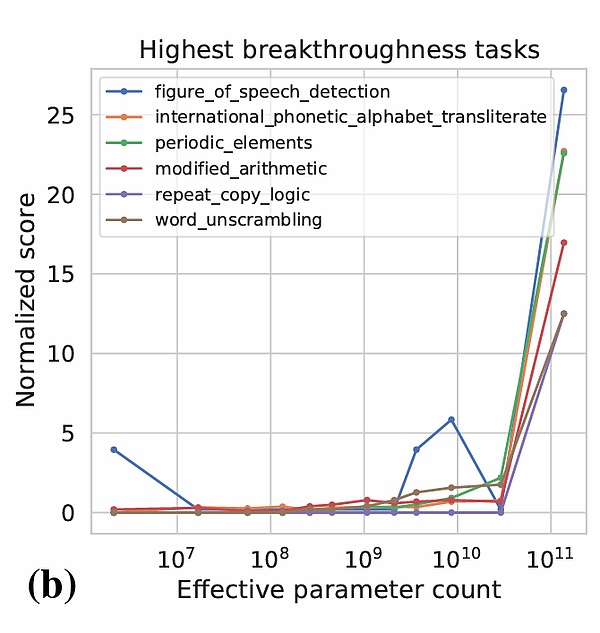

第三种是U型曲线。某些情况下,模型初期性能下降,但随规模增加又回升。

图片来源:Google:Inverse scaling can become U-shaped

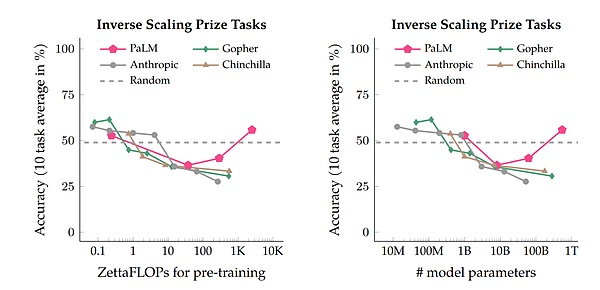

两种被证明具备“涌现”的典型能力:

上下文学习(ICL)和思维链(CoT)

ICL允许模型通过少量示例快速学习;CoT则提升了模型的推理能力。

图片来源:Google Brain Team:Chain of thought prompting elicits reasoning in large language models

多大的模型规模会出现“涌现”?

研究表明,68B参数是一个基础门槛,最好超过100B。

ICL情形下,出现能力涌现所对应的模型规模。图片来源:Google、Stanford、DeepMind:Emergent Abilities of Large Language Models

涌现现象的出现推动了AI向“真正的人工智能”迈进,但也带来了新的挑战。

正如微软在论文中指出,我们需要进一步探索AI的工作机制,制定针对通用人工智能的法律规范。

附录:文中引用的相关论文详见原文链接。

币安网

币安网 欧易OKX

欧易OKX HTX

HTX Coinbase

Coinbase 大门

大门 Bitget

Bitget Bybit

Bybit 双子星(Gemini)

双子星(Gemini) Upbit

Upbit Crypto.com

Crypto.com 泰达币

泰达币 以太坊

以太坊 比特币

比特币 USD Coin

USD Coin Solana

Solana 币安币

币安币 瑞波币

瑞波币 First Digital USD

First Digital USD 狗狗币

狗狗币 OFFICIAL TRUMP

OFFICIAL TRUMP